在《LLM在企业落地哪种方式更好:纯Prompt或微调?》中,企业在落地LLM时,开始都会尝试使用纯Prompt的方式进行效果的验证,那么如何提升基于提示词的LLM输出效果呢?

1.纯提示词方式驱动LLM输出

该方式即基于自身任务构建相应的提示词,然后输入到LLM模型,驱动模型输出自己想要的结果。简单任务还好,一旦涉及到复杂一点的任务,LLM的输出结果往往差强人意。

虽然提示词的构建质量好坏对LLM的输出有较大影响,但是从实际结果来看,任务复杂程度对结果的影响比提示词构建质量更大。

因此,在企业中要充分发挥基于提示词驱动LLM的输出效果,拆解任务是一种重要的手动。

2.基于任务拆解的LLM效果提升

为了提升基于纯提示词的LLM输出结果,需树立这样一个意识:只使用一个提升词来获取自己想要的最终结果,结果往往都不会太好。

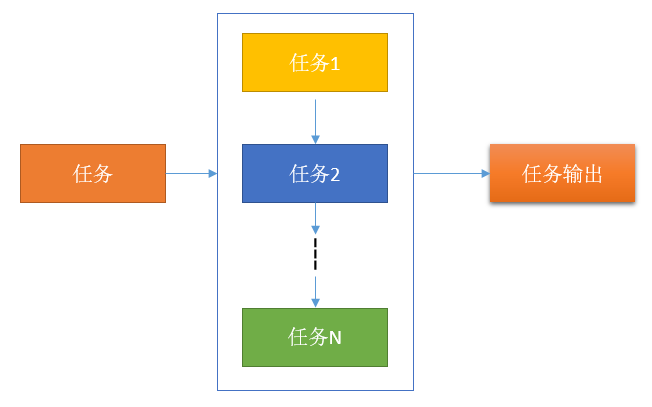

正确的做法是将一个任务拆解为1-N个任务,并使用最后一个任务的结果作为最终的结果。例如:

以从客户与经理的通话数据中提取竞品信息为例,我们可将该任务拆解为:

任务1:从对话中获取竞品信息(名称,利率等)的具体值与对应的对话

任务2:判断获取的某个竞品信息对应的对话内容是否与值相匹配

任务3:将相关值转换为具体的输出格式,例如月利率转换为年利率,汉字价格转换为数字价格等等。

当然你也可以使用一个提示词来做上面的三个任务,但效果肯定是没有任务拆解后的效果好。

3.人工拆解任务还是LLM自动拆解任务

对于输入的一个提示词的任务可拆解为多少个子任务进行执行,有人工拆解与LLM自动拆解任务并执行。

人工拆解方法往往比较固定,适用于对任务扩展性不强的领域,比如前期的技术探索阶段。

LLM自动拆解相对而言更加灵活,适用于相关任务可靠性较强的场景(这种方式也算是一种简单的LLM Agent应用)。

综上,为了提升纯提示词驱动LLM输出结果的准确性,拆解一个任务为多个子任务可以算是一种低成本的快速提升方法。

治伦AI

治伦AI